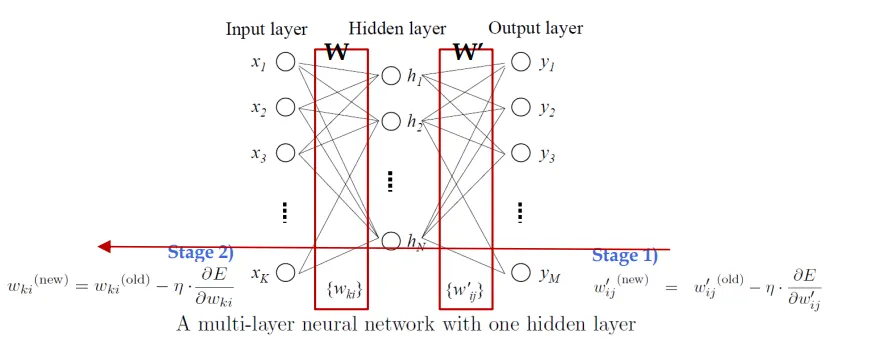

이 식들은 두 층으로 이루어진 신경망 모델에서의 전방 전파(forward propagation)와 오차 함수(error function)의 계산 방법을 설명합니다. 신경망은 일반적으로 입력층(input layer), 하나 이상의 은닉층(hidden layers), 그리고 출력층(output layer)으로 구성됩니다. 여기서는 입력층에서 은닉층으로, 그리고 은닉층에서 출력층으로의 데이터 흐름과, 이때의 오차를 계산하는 방법을 살펴보겠습니다.

전방 전파 (Forward Propagation)

•

은닉층의 활성화:

이 식은 입력층에서 은닉층으로의 데이터 전달을 나타냅니다. 여기서 \(x_k\)는 입력층의 뉴런에서의 입력 값, \(w_{ki}\)는 입력층의 뉴런 \(k\)와 은닉층의 뉴런 \(i\) 사이의 가중치, \(h_i\)는 은닉층 뉴런 \(i\)의 출력 값입니다. \(\sigma\)는 시그모이드 활성화 함수를 의미하며, 이 함수를 통해 비선형 변환을 수행합니다.

•

출력층의 활성화:

이 식은 은닉층에서 출력층으로의 데이터 전달을 나타냅니다. 는 은닉층의 뉴런 와 출력층의 뉴런 사이의 가중치, 는 출력층 뉴런 의 최종 출력 값입니다.

오차 함수 (Error Function)

•

제곱합 오차 함수

•

이 식은 네트워크의 출력 \(y_j\)와 실제 목표 값 \(t_j\) 사이의 오차를 측정하는 제곱합 오차 함수입니다. 여기서 \(M\)은 출력층의 뉴런 수입니다. 오차 함수의 목적은 이 값을 최소화하는 것으로, 이를 통해 신경망의 가중치들이 적절히 조정됩니다.

이 과정은 신경망이 학습하는 기본적인 방법으로, 입력 데이터에 대한 신경망의 출력을 계산하고(전방 전파), 계산된 출력과 실제 목표 값 사이의 오차를 기반으로 신경망의 가중치를 조정합니다(역전파). 오차 함수의 최소화는 경사 하강법(Gradient Descent)과 같은 최적화 기법을 사용하여 수행됩니다. 이 과정을 통해, 신경망은 주어진 입력 데이터에 대해 정확한 예측을 할 수 있도록 학습됩니다.

연세대학교 신원용 교수님 수업참고하였습니다.